양자 AI 알고리즘 개발…기존 AI 뛰어넘나

머니투데이 류준영 기자

2020.07.07 11:17

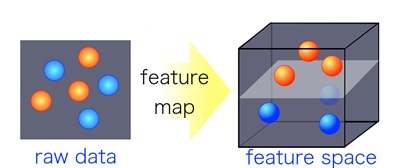

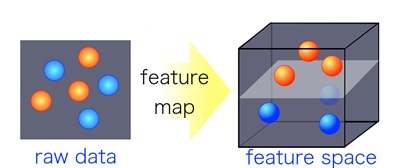

인공지능을 통한 분류에 있어 비선형 커널을 이용한 특징 분류 기술/사진=KAIST

인공지능을 통한 분류에 있어 비선형 커널을 이용한 특징 분류 기술/사진=KAIST 카이스트(KAIST) AI(인공지능) 양자컴퓨팅IT인력양성연구센터 이준구 교수 연구팀이 독일·남아프리카공화국 연구팀과의 협력 연구를 통해 비선형 양자컴퓨터 기계학습을 위한 AI 알고리즘을 개발했다고 7일 밝혔다.

양자컴퓨터는 ‘0’ 또는 ‘1’의 두 가지 상태로 정보를 표시하는 고전 컴퓨팅과 달리 상태의 중첩으로 있을 수 있는 양자 비트 또는 큐비트를 정보로 다룬다. 이에 따라 기존 컴퓨터로는 풀 수 없는 문제를 양자역학적 물리 현상을 이용해 빠른 속도로 풀 수 있다.

하지만 양자컴퓨터는 본질적으로 일차방정식을 잘 푸는 선형적 성질을 가지고 있어 복잡한 데이터를 다루는 AI 분야 비선형적 기계학습(머신러닝)에 적용하기 어렵다.

기계학습에 있어 중요한 문제 중 하나는 데이터의 특징을 구분해 분류하는 것이다. 이를 테면 개와 고양이를 분류하는 작업을 할 경우 코와 같이 데이터의 특징이 잘 나타나는 경우에는 선형적 알고리즘을 학습해 분류할 수 있지만, 입과 귀 등 비슷한 모양의 특징을 분류하려면 비선형적 알고리즘이 필요하다.

연구팀은 양자데이터 간의 유사성을 효율적으로 계산하는 비선형 양자 알고리즘 체계를 개발한 뒤 실제 IBM 클라우드 서비스를 통해 실제 양자컴퓨터에서 시연하는데 성공했다. 이 체계는 무엇보다 매우 적은 계산량으로도 연산이 가능해 대규모 계산량이 필요한 현재의 AI 기술을 추월할 가능성을 제시했다는 평가를 받는다. 연구팀은 “복잡한 비선형 데이터의 패턴 인식 등을 위한 양자 기계학습 알고리즘으로 활용할 수 있을 것”이라고 말했다. 이번 연구성과는 국제학술지 ‘엔피제이 퀀텀 인포메이션’에 게재됐다.

<저작권자 @머니투데이, 무단전재 및 재배포 금지>

인공지능을 통한 분류에 있어 비선형 커널을 이용한 특징 분류 기술/사진=KAIST

인공지능을 통한 분류에 있어 비선형 커널을 이용한 특징 분류 기술/사진=KAIST