Q4-3-2. 인공지능 시스템이 의도한 대로 작동하지 않거나 인권에 미치는 부정적인 영향이 확인됐을 때 관련된 책임을 명확히 하고 인공지능 시스템을 개선하며 부정적 영향을 완화하기 위해 필요한 절차를 수립했습니까.

최근 국가인권위원회가 공개한 '인공지능(AI) 인권영향평가 도입 방안' 연구용역보고서에 담긴 AI 인권영향평가도구안의 문항이다. '챗GPT' 등 AI 기술 고도화가 가져올 인권 침해를 선제적으로 따져본다는 취지다. AI 발전과 확산으로 인한 개인정보·사생활에 관한 권리 침해, 차별 등 인권 문제에 대한 우려를 반영했다.

주요 선진국과 기업도 AI의 인권영향평가를 도입하는 추세다. 유엔 인권최고대표, 유엔인권이사회는 지난해 국가나 기업에서 AI 시스템에 대한 인권 실사를 권고했다. 구글, 페이스북, 마이크로소프트 등 빅테크 기업들도 자사의 AI에 대해 인권영향평가를 수행했다.

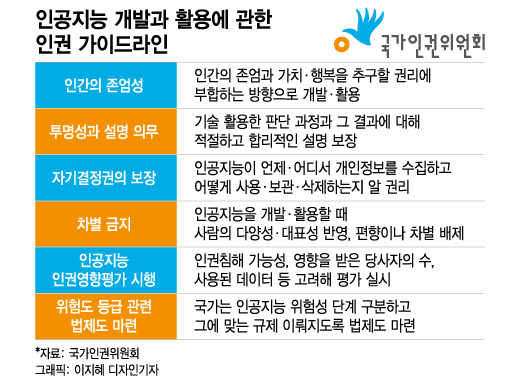

인권위는 국무총리와 과학기술정보통신부장관, 개인정보보호위원장, 방송통신위원장 등 각 부처 장관과 기관장 등에게 이 가이드라인에 기초해 인공지능 관련 정책을 수립·이행할 것을 권고했다. 평가 대상으로 △소방 △응급의료 △신원확인 △인사채용·평가 △범죄수사 △출입국 관리 △법률 해석 등 다양한 분야가 꼽힌다.

AI 인권영향평가 도입에 앞서 명확한 법률적 근거를 마련해야 한다는 지적도 나온다. 현재는 인권영향평가를 받아야 하는 대상이 법제화돼 있지 않다.

이 시각 인기 뉴스

연구진은 보고서에서 "우리 법제에 난립돼 있는 영향평가제도 가운데 인권영향평가의 성격과 위상이 아직 불분명하고 규제영향평가 등은 AI 인권영향평가 제도를 온전히 실현하기에 여러 한계점이 있다"며 "기존 국가인권위원회법 개정이나 새로운 입법을 통해 AI 인권영향평가를 도입하는 방안을 단계적으로 검토할 필요가 있다"고 밝혔다.