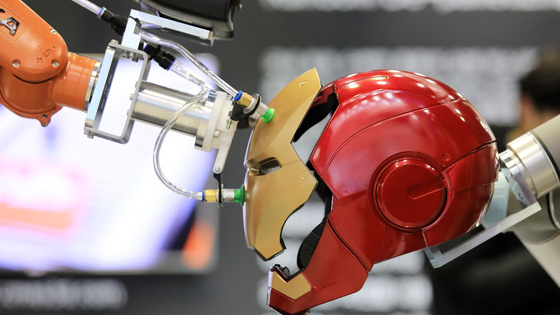

(서울=뉴스1) 구윤성 기자 = 6일 서울 강남구 코엑스에서 열린 '스마트팩토리·자동화산업전(SFAW) 2022'에서 협동로봇이 '아이언맨' 마스크를 조립하고 있다. 스마트공장, 자동화산업 분야에서 아시아 최대 규모 종합 전시회인 이번 행사는 오는 8일까지 코엑스 전시홀 전관에서 열린다. 2022.4.6/뉴스1

(서울=뉴스1) 구윤성 기자 = 6일 서울 강남구 코엑스에서 열린 '스마트팩토리·자동화산업전(SFAW) 2022'에서 협동로봇이 '아이언맨' 마스크를 조립하고 있다. 스마트공장, 자동화산업 분야에서 아시아 최대 규모 종합 전시회인 이번 행사는 오는 8일까지 코엑스 전시홀 전관에서 열린다. 2022.4.6/뉴스1 최근 AI 커뮤니티를 들썩이는 소문이 돌고 있다. 차세대 AI 모델 GPT-4가 튜링테스트를 통과했다는 것. 튜링테스트는 AI가 얼마나 사람과 자연스럽게 소통할 수 있느냐를 측정하는 테스트다. AI 업계에 따르면 지금까지 튜링테스트를 완벽하게 통과한 모델은 없었다.

문장만 넣으면 답변도 척척…오픈AI 'GPT'

각 버전의 차이는 파라미터(매개변수)다. 첫 모델인 GPT-1은 1억1700만개, GPT-2는 15억개, GPT-3는 1750억개의 파라미터를 갖췄다. 파라미터는 데이터가 들어왔을 때 일정 가중치로 결과물을 만든다. 같은 데이터가 들어와도 파라미터에 따라 결과물은 다를 수 있다. 파라미터가 많으면 많을수록 단순한 번역부터 프로그램 코딩까지 GPT의 확장성은 그만큼 커진다.

GPT는 GPT-2에서 GPT-3로 넘어오면서 격변기를 맞는다. GPT-2가 제대로 작동하려면 학습데이터를 넣고 트레이닝을 거쳐야 한다. 반면 GPT-3는 트레이닝이 필요 없다. 문장 몇 줄만 넣으면 바로 작동한다. 개발자가 아니라도 누구나 쉽게 GPT 모델을 이용할 수 있다.

이 시각 인기 뉴스

GPT-4 볼륨보다 효율…"코딩에 초점 맞춰

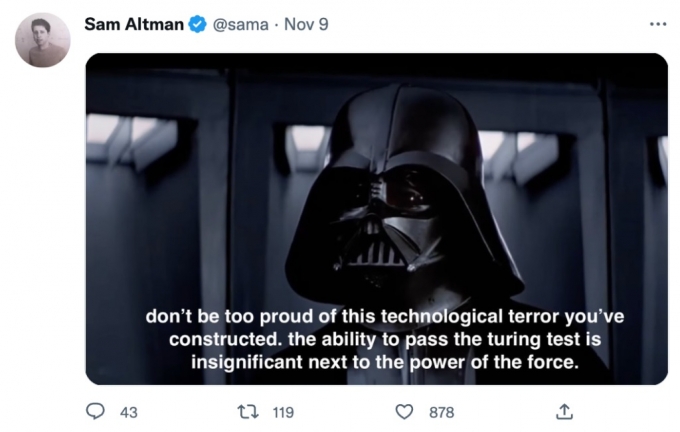

지난 9일(현지시간) 샘 알트만 오픈AI CEO은 자신의 트위터에 튜링테스트와 관련된 포스트를 게재했다. /사진=샘 알트만 트위터

지난 9일(현지시간) 샘 알트만 오픈AI CEO은 자신의 트위터에 튜링테스트와 관련된 포스트를 게재했다. /사진=샘 알트만 트위터지난해 알트먼 CEO는 AC10 온라인 미팅 질의응답 세션에서 GPT-4와 관련해 "GPT-3와 비교해 파라미터는 큰 차이가 없을 것"이라며 "컴퓨팅 리소스를 얼마나 더 효율적으로 활용할 수 있느냐에 초점을 맞추고 있다"고 말했다. 작은 모델이라도 효율적으로 작동할 수 있도록 하겠다는 것.

알트먼 CEO는 또 GPT-4는 코딩 부문에 초점을 맞출 것이라고 밝혔다. 오픈AI는 이미 GPT-3를 기반으로 한 AI 코딩 모델 '코덱스'를 선보인 바 있다. 별도의 코딩 작업 없이도 대화하듯이 필요한 정보를 입력하면 코덱스가 알아서 코드를 짜고 앱을 만드는 모델이다. GPT-4가 코딩 측면에서 GPT-3보다 발전된 모습을 보일 수 있다면 비개발자의 앱 개발도 보다 손쉬워진다.

그러나 이같은 GPT-4의 파급력이 AI 업계 전체로 퍼져나갈지는 미지수다. 비용적인 측면에서 GPT에 대한 접근도가 크게 떨어지기 때문이다. 한 AI 스타트업 대표는 "GPT-3 기반으로 챗봇을 만들어 2시간 정도 사내에서 채팅했더니 30만원 정도 나왔다"며 "글자 수대로 가격이 책정되다 보니 유의미한 결과를 얻기까지 비용이 상당하다. 실제 서비스는 엄두도 못 낸다"고 말했다.

이 때문에 대부분 스타트업은 오픈 API(응용프로그램 인터페이스)로 공개된 GPT-2를 튜닝해 사용하고 있다. 트레이닝 과정을 거쳐야 하기 때문에 GPT-3보다 개발 기간은 길지만, 입맛에 맞는 모델을 만들기엔 GPT-3보다 오히려 낫다는 평가도 나온다.

한 AI 업계 관계자는 "GPT-4에 대해 공개된 정보가 적어 아직 섣불리 판단하긴 힘들지만, AI 업계 미치는 영향을 상당할 것"이라며 "인간과 AI 간극은 더욱 줄어들 것"이라고 말했다.

[머니투데이 스타트업 미디어 플랫폼 '유니콘팩토리']